¿DÓNDE ESTÁ LA ISS AHORA?

miércoles, 16 de diciembre de 2015

Scientists watch a planet being born for the first time in history

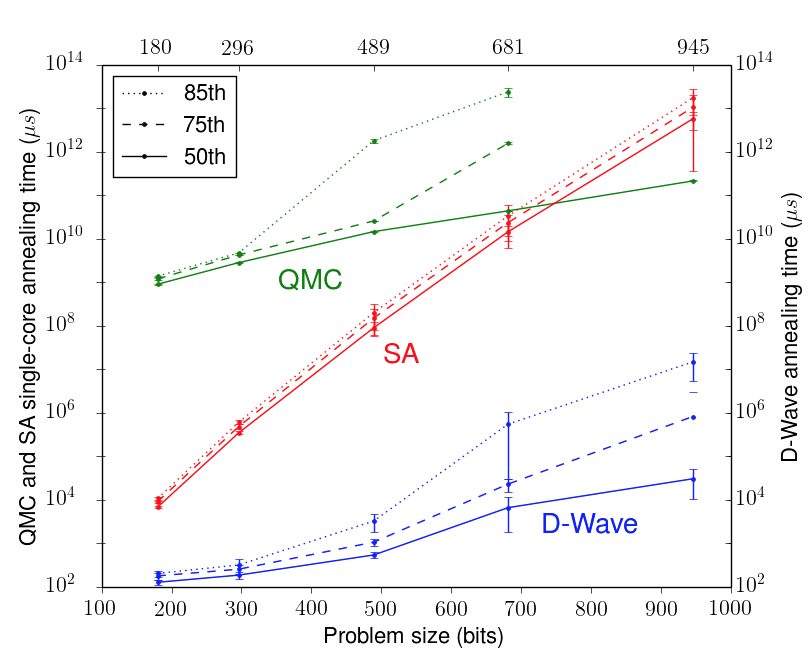

Google, NASA: Our Quantum Computer Is 100 Million Times Faster Than A Normal PC

Scientists explain origin of heavy elements in the Universe

Computing with time travel

Provided by: National University of Singapore

A fundamental quantum physics problem has been proved unsolvable

martes, 2 de junio de 2015

lunes, 1 de junio de 2015

lunes, 25 de mayo de 2015

sábado, 23 de mayo de 2015

martes, 19 de mayo de 2015

viernes, 15 de mayo de 2015

miércoles, 13 de mayo de 2015

domingo, 10 de mayo de 2015

martes, 5 de mayo de 2015

sábado, 2 de mayo de 2015

jueves, 30 de abril de 2015

domingo, 26 de abril de 2015

sábado, 11 de abril de 2015

La teoría de la relatividad especial, explicada de manera sencilla

La teoría de la relatividad especial, explicada de manera sencilla

La teoría de la relatividad especial, formulada por Albert Einstein en 1905, constituye uno de los avances científicos más importantes de la historia. Alteró nuestra manera de concebir el espacio, la energía, el tiempo y tuvo incluso repercusiones filosóficas, eliminando la posibilidad de un espacio/tiempo absoluto en el universo.

Se complementa con la teoría de la relatividad general, publicada en 1915, algo más compleja y que pretende aunar la dinámica newtoniana con parte de las consecuencias de la primera teoría especial.

Con la teoría de la relatividad especial, la humanidad entendió que lo que hasta ahora había dado por sentado que era una constante, el tiempo, era en realidad una variable. No sólo eso, sino que el espacio también lo era y que ambos dependían, en una nueva conjunción espacio-tiempo, de la velocidad.

Luis Álvarez-Gaumé, director del grupo de física teórica del CERN, nos explica en conversación telefónica:

Lo más importante es entender cómo el tiempo depende, en realidad, del movimiento, de la velocidad. Eso fue lo que lo cambió todo.

Einstein se basó a su vez en dos hipótesis:

- Las leyes de la física son las mismas mientras el sistema de referencia sea el mismo e inercial. Esto es, ambos se mueven a una velocidad constante. Si una ley se cumple en un sistema, también se debe cumplir en el otro.

- La velocidad de la luz es una constante universal, que se define como c. Que era constante lo habían demostrado algunos años antes otros dos grandes científicos, Michelson y Morley.

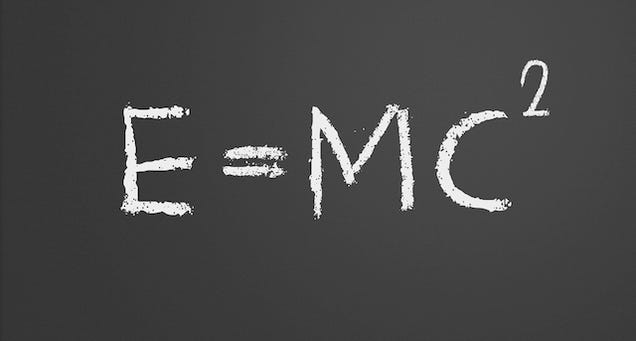

Pero para llegar al famoso E = mc2 antes tenemos que entender dos conceptos muy importantes: por un lado qué es exactamente la relatividad y por otro lado entender el espacio-tiempo y cómo define lo que se conoce como líneas de universo. Por último, aunque no deduciremos los pasos matemáticos necesarios para llegar hasta la ecuación, veremos las consecuencias que tiene y cómo se relaciona dentro de la teoría de la relatividad general. Vamos allá.

Qué es la relatividad

La situación que imaginó Einstein ha sido usada y explicada hasta la saciedad en escuelas y libros de física. Imaginemos un tren y a dos individuos, uno de ellos está montado en el mismo y otro lo ve pasar a toda velocidad desde el borde de la vía. El tren se mueve a 200 kilómetros por hora.

Un momento, ¿se mueve? ¿seguro? Sí y no al mismo tiempo. Para la persona que va sentada dentro el tren no se mueve, está quieto. Sólo se mueve para la persona que está al borde de la vía. Es algo, efectivamente, relativo.

Einstein luego imaginó que alguien tira una pelota a 20 kilómetros por hora hacia delante dentro del tren. Para la persona que está dentro la pelota se mueve a esa velocidad pero para la persona que está abajo esa pelota se mueve , sin embargo, a 220 (200+20) kilómetros por hora.

Ahí es cuando toca recordar que la velocidad de la luz es constante, y es cuando empezamos a entender que algo no encaja del todo con el concepto de que el tiempo también lo sea. Puesto que la velocidad de la luz siempre es la misma, al volver al ejemplo del tren y la persona que está dentro si en lugar de lanzar una pelota enciende una linterna proyectando un haz de luz hacia delante, la persona que está abajo no ve ese haz propagarse a la velocidad de la luz+200 km/h, la ve propagarse a la velcoidad de la luz, sin más, independientemente de lo rápido o lo lento que vaya el tren porque, simplemente, es una constante.

Para entender un poco mejor el concepto veamos el siguiente ejemplo. Muestra dos fotones de luz rebotando infinitamente entre dos espejos y tomándose un tiempo x en ir de uno a otro.

La velocidad de la luz (y al contrario que el tiempo) sí es constante. Esto lo habían demostrado algunos años antes que Einstein otros dos físicos, Michelson y Morley. Teniendo en cuenta que la velocidad de la luz siempre es la misma (casi 300.000 kilómetros por segundo), veamos ahora el siguiente ejemplo.

Puesto que el primer carrito se mueve a una velocidad constante, desde nuestro punto de vista el fotón tiene que recorrer una diagonal (más distancia) entre un espejo y otro variando el tiempo efectivo que tardar en rebotar. El tiempo, desde nuestro punto de vista estático, acaba de variar con respecto al de alguien que estuviese mirando dentro (que siempre verá como el fotón rebota de manera regular, se mueva el carrito o no).

Pero, ¿por qué no apreciamos la distorsión del tiempo en la vida diaria? Básicamente, porque las distorsiones sólo se producen en velocidades cercanas a las de la luz. Como referencia, el artefacto más rápido construido jamás por el hombre, las sondas Helios, siguen siendo 15.000 veces más lentas que la velocidad de la luz. Es el equivalente a si sobre una tortuga caminando lentamente sobre la superficie de la tierra pasase en vuelo rasante un avión supersónico. Con un avión supersónico moviéndose a 2470 kilómetros por hora, que para nosotros es ya una velocidad considerable el tiempo se alarga con un factor de 1,000000000002. Es muy pequeño. Si viajásemos durante un año nuestro tiempo se alargaría 0,000063 y aún cuando pasásemos 50 años metidos en él volando a esa velocidad, el tiempo se habría alargado sólo 0,0032 segundos.

Viajar en el tiempo es posible, te explicamos cómo

Viajar en el tiempo ha sido una de las fantasías del ser humano por siglos. Es una tendencia…Seguir leyendo

Sabiendo entonces que el tiempo no es una constante, sino que depende de la velocidad, aparece la paradoja de los dos gemelos. Narra el hipotético caso de dos gemelos, uno que pasa 10 años viajando en el espacio a altas velocidades (la mitad de la luz, 150.000 km/s, por ejemplo) y otro que se queda en la tierra. Después de ese tiempo, el gemelo astronauta vuelve a la tierra y comprueba que, puesto que el tiempo ha pasado de manera distinta y ha sido más lento para él, su hermano es casi una década más viejo. ¿Ha vivido más? ¿Son los viajes a altas velocidades una fuente de eterna juventud? No, sólo ha vivido menos porque el tiempo ha pasado más lento para él, ha pensado menos, ha crecido menos y ha madurado menos. Lo único que ha ocurrido es que el tiempo ha pasado más despacio.

Lo curioso de todo, es que el observador no tiene manera de saber si se está moviendo o no si no tiene un sistema contra el que compararse. Estamos hablando de trenes, de hecho, mientras la Tierra se mueve a toda velocidad por la Vía Láctea, y con ella el universo. La realidad es que ahora mismo, aunque estés leyendo esto sentado o tumbado, estás de todo menos "quieto".

El espacio-tiempo

En palabras de Luis Álvarez Gaumé:

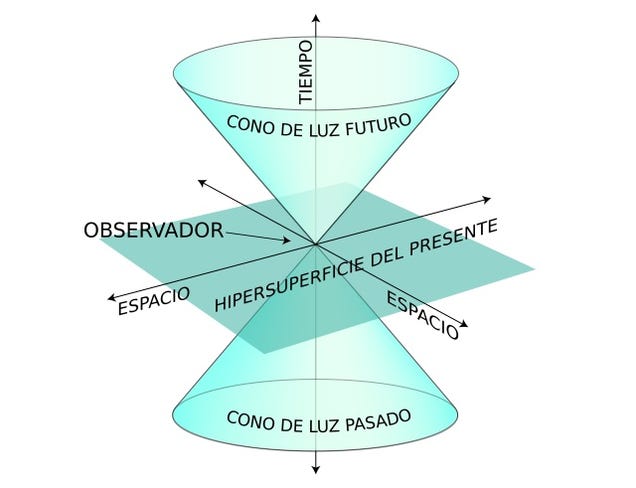

La revolución de la teoría de la relatividad es que crea un cono de luz, tanto hacia delante en el tiempo, como hacia detrás. Puesto que lo que define los límites de ese cono es la velocidad de la luz y ninguna partícula puede superarla, nada de lo que ocurra puede estar fuera de los límites del mismo.

Este es el cono

Ese cono describe al observador moviéndose por la hipersuperficie que es el presente. Hacia "arriba" quedan los eventos del futuro, lo que va a ocurrir. Cualquier posibilidad o hecho tiene que ocurrir dentro de ese cono. Hacia abajo quedan los eventos que te han ocurrido.

Añade Gaumé: " Y cuidado, no es que no "ocurran" cosas fuera de ese cono, sí ocurren, sólo que no pueden afectarte. Para que pudiesen afectarte tienen que superar la velocidad de luz. El cono es independiente de la velocidad de movimiento del observador. Eso es lo que fuerza a que el tiempo dependa del estado del movimiento".

El cono delimita eventos que puedan tener efecto sobre otros. La línea del universo es la unión de la infinidad de puntos correspondientes a todos lo que ha ocurrido en tu vida. Siempre dentro del cono.

E = mc2

A E = mc2 se llega a raíz de una serie de ecuaciones que, debido al carácter más accesible de este post, no tiene sentido explicar aquí aunque para quien tenga conocimientos medios de física y matemática hay una explicación bastante buena aquí. Para llegar hasta la ecuación hace falta tener en cuenta dos leyes importantes:

- Ley de conservación del momento lineal: qué básicamente quiere decir que cuando dos objetos entran en colisión a distinta velocidad (y por tanto diferente momento lineal) la resultante de la suma de ambos objetos ha de tener el mismo valor antes y después.

- La famosa ley de conservación de la energía: La energía ni se crea ni se destruye, sólo se transforma. Cambia de una forma de energía a otra.

Lo verdaderamente interesante de la ecuación es que relaciona de manera directa masa y energía. Son transformables. Y hasta Einstein nadie se había dado cuenta y se pensaba que eran cosas independientes.

Explicándolo un poco mejor: pongamos por ejemplo un tronco de leña quemándose en una chimenea. Una vez se ha quemado si sumamos la masa correspondiente a todas las cenizas más los gases que ha emitido, apreciaríamos que que la masa total ha disminuido, aunque sea minúscula. Esa masa es la que se ha transformado en energía, el calor de la combustión.

En el caso de la leña no es muy eficiente, pero en el caso de las centrales nucleares, por ejemplo, es mucho mayor y por eso la utilizamos para la producción de energía.

Aunque ya es carne de otro post, la manera en la que energía, masa y espacio-tiempo se relacionan es lo que se conoce como Teoría de la Relatividad General. Y ahí es donde entra en juego la gravedad. Sin embargo, la teoría de la relatividad considera que los efectos gravitatorios no son creados por fuerza alguna, sino que encuentran su causa en la curvatura del espacio-tiempo generada por la presencia de materia. Cuando la gravedad aumenta de manera brutal, como ocurre en los agujeros negros, es cuando se producen esas curvaturas extremas que pueden apreciarse en películas como Interstellar.

Imagen: Roland IJdema/Shutterstock

12 formas en las que la humanidad podría destruir todo el Sistema Solar

12 formas en las que la humanidad podría destruir todo el Sistema Solar

Los seres humanos estamos haciendo un excelente trabajo destruyendo nuestro propio planeta poco a poco, pero ¿quién dice que no podemos salir y destruir cosas en otros lugares. A continuación, y sin un orden particular, os presentamos 12 formas no intencionadas en las que también podríamos ocasionar serios daños en el Sistema Solar.

Huelga decir que todo esto contiene altas dosis de especulación y ciencia-ficción.

Un desastre en un acelerador de partículas

Antes de que el CERN construyera el gran acelerador de partículas, algunos científicos expresaron su preocupación sobre la posibilidad de que las colisiones produjeran reacciones adversas como burbujas de vacío, monopolos magnéticos, agujeros negros microscópicos o anomalías como los strangelets de materia extraña, una forma hipotética de materia similar a la que conocemos, pero que incorpora también quarks y que, al chocar con materia normal, también la convierte en materia extraña.

Las quejas, por supuesto, fueron enterradas por la comunidad científica, que las calificó como basura y rumores extendidos por personas sin cualificar en busca de simple publicidad. Un informe publicado en 2011 llegó a la conclusión que las colisiones no suponían ningún riesgo.

Anders Sandberg es un investigador que trabaja en el Instituto para el Futuro de la Humanidad, una institución mucho más seria de lo que apunta su nombre que forma parte de la Universidad de Oxford. Sandberg está de acuerdo en que un accidente en el LHC es muy improbable, pero si tomamos el ejemplo de los strangelets como cierto, su liberación sería catastrófica.

Convertir incluso un planeta tan pequeño como Marte en materia extraña liberaría una fracción de la masa como energía (y probablemente otros strangelets). Asumiendo un índice de conversión en un plazo de una hora y con una conversión de masa de solo el 0,1%, la radiación resultante sería 42 millones de veces la del Sol. La mayor parte de esta radiación serían rayos gamma.

¡Ouch! Obviamente, el LHC es incapaz de producir materia extraña, pero futuros experimentos en la Tierra o en el espacio podrían tener éxito. Se especula, por ejemplo, con que el núcleo de las estrellas de neutrones está formado por materia extraña a altísimas presiones. Si logramos recrear esa materia de repente, sería un final realmente rápido. Foto: The Core

Un proyecto de ingeniería estelar que sale horriblemente mal

Algunos futurólogos especulan con que los seres humanos (o sus descendientes) podrían decidir realizar experimentos de ingeniería estelar. En su obra Interstellar Migration and the Human Experience David Criswell de la Universidad de Houston describe estos experimentos como intentos por controlar la evolución o las propiedades de las estrellas. Entre esos intentos podría estar el tratar de prolongar su vida, extraer material de la estrella o crear nuevas estrellas. En teoría, si se pudiera extraer masa de una estrella, se podría hacer que esta se consumiera más despacio.

El potencial de catástrofe de estas operaciones es bastante elevado. La ingeniería estelar podría producir efectos en cascada incontrolables. Por ejemplo, extraer masa del sol podría desencadenar destellos solares imprevistos y peligrosos, o incluso reducir tanto su luminosidad que supusiera un riesgo para la vida. Asimismo, podría alterar las órbitas del resto de planetas (ver más abajo). Foto: NASA / JPL

Un intento fallido de convertir Júpiter en una estrella

No es la primera vez que se piensa en la posibilidad de convertir Júpiter en una especie de estrella artificial, pero ello podría destruir el planeta y, de paso, la vida en la Tierra.

El astrofísico Martin Fogg propuso en la publicación Journal of the British Interplanetary Society que convertir Júpiter en una estrella podría ser el primer paso para hacer habitables sus satélites. Para ello solo (casi nada) habría que generar un pequeño agujero negro cuidadosamente creado para que no se saliese de los límites de Eddington (un punto de equilibrio entre la radiación y la gravedad). Según Fogg, esto crearía suficiente energía como para calentar Europa y Ganímedes a niveles de La Tierra y Marte respectivamente.

Suena bien, pero no hay manera de saber hasta qué punto se mantendría el equilibrio. Como explica Sandberg, si el agujero negro crece y eventualmente absorbe Júpiter, la radiación resultante esterilizaría completamente el sistema Solar. Eso por no mencionar que en lugar de Júpiter iba a quedar un agujero negro. El vecindario iba a quedar un poco estropeado.

Manipular la dinámica orbital de los planetas

Empezar a enredar con la localización o masa de los planetas o demás objetos del Sistema Solar puede hacer que se desequilibre el delicado equilibrio entre las órbitas.

Aunque sorprenda, las dinámicas orbitales de nuestro Sistema Solar son muy frágiles. Se estima que hasta la más mínima perturbación puede alterar estas órbitas de forma caótica y potencialmente peligrosa. La razón de esto es que los planetas están sujetos a resonanciasdebido a la periodicidad con la que interactúan. Neptuno y Plutón, por ejemplo, tienen una resonancia orbital de 3:2. Plutón completa dos vueltas en el tiempo en el que Neptuno completa 3. Los encuentros cercanos y regulares pueden acabar con un objeto menor expulsado fuera de su órbita original e incluso del Sistema Solar.

En un futuro lejano estas resonancias caóticas podrían ocurrir de manera natural, o podríamos causarlas experimentando con ingeniería estelar, con la idea de mover Marte a una zona habitable, o tratando de construir una esfera de Dyson con materiales de Mercurio y Venus.Ilustración: Hagai Perets.

Proponen un nuevo tipo de esfera de Dyson prácticamente indetectable

La esfera de Dyson es uno de los conceptos más fascinantes de la física y la ciencia ficción. ¿Y si …Seguir leyendo

Maniobrar torpemente un motor Warp

Una nave con un motor Warp sería algo asombroso, sí, pero también supondría un peligro enorme por las energías a las que se vería sometido el punto de destino.

Conocido también como motor de Alcubierre, un motor warp funcionaría generando una burbuja de energía negativa a su alrededor, expandiendo el espacio y el tiempo detrás de la nave y reduciéndolo delante para viajar más rápido que la luz. Sin embargo, esta burbuja tiene tambien el potencial de hacer mucho daño. En 2012, un equipo calculó lo que un motor Warp podría hacer y lo publicó en la revista Universe Today. Jason Mayor lo explica así:

El espacio no es solo un vacío entre el punto A y el punto B. En realidad está lleno de partículas que tienen masa y otras que no. Lo que el equipo de investigadores ha descubierto es que estas partículas pueden ser atraídas por la burbuja y arrastradas delante y detrás de ella.

Cuando el motor de Alcubierre decelere a velocidades inferiores a la de la luz, las partículas son liberadas en haces de energía. Las de la parte delantera pueden ser muy potentes, lo bastante como para destruir cualquier objeto directamente delante de la nave.El estudio concluye que cualquier objeto o seres delante de la nave a su llegada serían simplemente destruidos por un haz de radiación gamma y partículas de alta energía.

El estudio añade que, incluso en viajes cortos, la energía que se libera es suficiente como para destruir cualquier objeto delante de la nave, y con cualquier objeto se refieren también a planetas enteros. Como la acumulación de energía depende de la longitud del viaje, no existe límite potencial a la descarga de partículas. Imagen: Mark Rdemaker.

Un accidente con un agujero negro artificial

Usar agujeros negros de gusano para realizar viajes interestelares suena bien en teoría, pero debemos ser muy cuidadosos antes de abrir un agujero en el tejido del espacio tiempo. En 2005, el físico nuclear iraní Mohammad Mansouryar diseñó una forma de crear un agujero de gusano transitable. Su teoría explicaba que si se creaban las suficientes partículas de materia extraña se podía crear una de estas singularidades. Andreas Sandberg apunta algunos de los inconvenientes graves de esta teoría.

En primer lugar, los agujeros de gusano necesitan una relación masa-energía equivalente a la de un agujero negro del mismo tamaño. En segundo lugar, los bucles temporales podrían causar que las partículas virtuales se vuelvan reales y causen un efecto cascada en el agujero, lo que no sería nada bueno para lo que haya en las inmediaciones. Por último, pon uno de los extremos cerca de una estrella y puedes destruirla, vaciando toda su radiación en otra región del espacio y aniquilando cualquier forma de vida que pueda haber en un sistema como el nuestro.

Un error catastrófico de navegación en un sistema Shkadov

¿Y si nos da por cambiar de sitio todo nuestro Sistema Solar en el futuro? El traslado podría saldarse con su completa destrucción.

En 1987, el físico ruso Leonid Shkadow formuló un concepto de megaestructura conocido como impulsor de Shkadow o sistema Shkadow. Se trata de un dispositivo capaz de mover de su sitio una estrella con todo lo que orbita alrededor de ella. Adam Hadhazy explica su funcionamiento en Popular Mechanics:

El impulsor de Shkadow es simple en teoría. Se trata de un espejo curvado colosal con su lado cóncavo apuntando al Sol desde una posición donde su atracción gravitatoria se compense con la presión ejercida por su radiación. El espejo se convierte en un satélite estable en equilibrio. La radiación reflejada por el espejo es capaz de mover la estrella lentamente. ¡Voilá! La humanidad ya está lista para viajar a lo grande.

¿Qué puede fallar, verdad? Un simple fallo de cálculo y podemos enviar el Sol a cualquier lugar o hacerlo chocar con otra estrella. La idea de mover todo un sistema solar implica que deberíamos ser capaces de mover también objetos para evitar causar un caos de proporciones estelares, con estrellas, planetas y cometas volando sin control en todas direcciones. Imagen: Steve Bowers.

Atraer alienígenas con malas intenciones

Si el programa SETI continua su andadura, seguiremos transmitiendo mensajes al espacio con la esperanza de que alguien los capte porque, ya sabes, todos los extraterrestres son buenas personas y todo eso. Foto: Mars Attacks.

El retorno de sondas modificadas von Neumann

Digamos que enviamos una flota de sondas Von Neumann capaces de autoreplicarse para colonizar la galaxia. Dependiendo de cómo estén de bien (o de mal) programadas y de su capacidad para adaptarse y evolucionar, es posible que regresen con intenciones menos sanas de las que tenían al partir. Eventualmente, podrían adquirir capacidades incluso superiores a las de nuestra civilización.

Un desastre interplanetario de plaga gris

En parte este desastre es similar al de las sondas von Neumann. La amenaza proviene en este caso de un ejército de nanobots capaces de autoreplicarse. La hipótesis se conoce como la plaga gris y apunta a una imparable legión de diminutos nanobots programados para consumir materia y replicarse casi como un virus. Podrían generarse en un planeta y escapar al espacio o incluso nacer como parte de un proyecto espacial fuera de control. Sea como sea, podrían extenderse por el Sistema Solar y consumir todos los recursos a su alcance.

Una superinteligencia fuera de control

Si ya jugamos con la hipótesis de que una inteligencia artificial decida acabar con la especie humana, ¿Por qué va a detenerse ahí? Podría perfectamente extender sus dominios por el Sistema Solar y más allá.

Existe un escenario hipotético conocido como Paperclip que resulta tan humorístico como inquietante, y es que una inteligencia artificial mal programada decida convertir todo lo que encuentra a su alcance en clips para sujetar papel. Es solo un ejemplo que remarca la urgencia de manejar la inteligencia artificial con mucho cuidado. Es dudoso que una IA fuera de control decida convertirlo todo en clips hasta la náusea, pero podría querer usar toda la materia a su alcsance para fabricar chips con los que mejorar su rendimiento. Ese imperativo podría trascender nuestro planeta y abarcar algo como toda la galaxia. Imagen:Stevebidmead/Pixabay/CC

Haciendo que el Sistema Solar no importe

¿Cómo conseguir que el Sistema Solar no sea más que una mota sin importancia en el universo? Muy sencillo, provocando nuestra total extinción. Foto: Udra11 / Shutterstock.